新智元报道

编辑:乔杨 好困

【新智元导读】OpenAI自研芯片的计划终于看到了实质性进展。根据SemiAnalysis最近的一篇文章,他们正从谷歌TPU团队招募人才,扩展自己的芯片研发组。

OpenAI在芯片方面的野心传闻已久。

目睹了近年来PC和AI行业两次重大的半导体供应危机之后,Sam Altman似乎认为台积电、三星代工和英特尔代工这些传统的芯片制造商没有足够的产能,不能满足全球对AI芯片迅猛增长的需求。

不仅仅是OpenAI的算力需要减少对英伟达芯片的依赖,奥特曼甚至还希望建造更多的晶圆厂,可以稳定供给其他公司。

根据华尔街日报的报道,今年2月,奥特曼会见软银CEO和台积电的谈判代表,讨论合资事宜,计划在未来几年内共同建造和运营数十座芯片制造工厂。

TSMC在亚利桑那州的在建工厂

然而,造芯片要烧的钱相比训练大模型,只会少不会多。

根据奥特曼本人的估计,要建造新的半导体制造设备和相关基础设施,成本可能高达5-7万亿美元。

由于传统的私人风投很难一下子拿出这么多资金,奥特曼曾经找到美国商务部长讨论,甚至远赴新加坡和阿联酋会见当地官员,想寻求国有资本的支持。

经过了半年多的筹备和发酵,OpenAI的芯片事业似乎真的要起步了!

芯片人才大战,谷歌 vs. OpenAI

据SemiAnalysis的最新报道,OpenAI最近开始大规模招募,计划将只有几个人的芯片团队扩展到几十个人。

而且,他们延续了招聘人才的一贯策略——挖角谷歌。

新近招募的几乎所有研究人员,都是现任或前任的谷歌TPU团队成员。

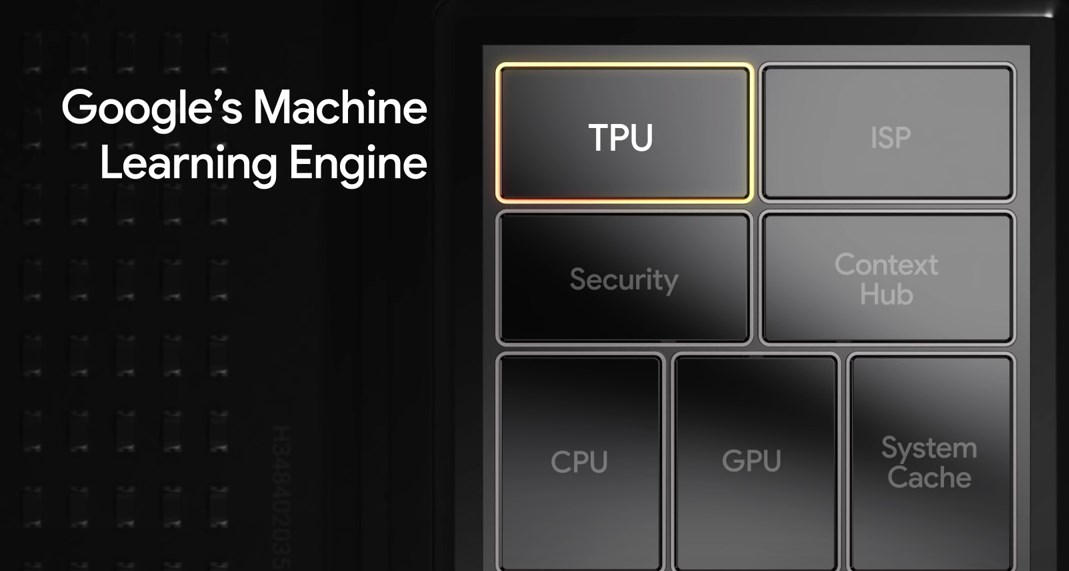

不同于最初为图形处理和实时渲染设计的GPU,TPU是谷歌从头设计的,专门用于加速机器学习和神经网络的计算,能够更出色地解决张量运算问题。

GPU以ALU(高级算术逻辑单元)作为核心组件,而TPU的核心是矩阵乘法器单元(MXU),能够以很高的吞吐量执行矩阵乘法和累加。

谷歌TPUv4

虽然TPU的任务通用性不如GPU,尤其是没有CUDA这样的编程接口,但在运算性能和能源效率方面表现出色,尤其是那些经过谷歌团队特别优化的任务。

因此可以说,TPU是世界上性能/TCO(总体拥有成本)最优的机器学习基础设施。

虽然谷歌的TPU已经有如此高的成就,但是OpenAI芯片团队的工作机会依旧有多方面的吸引力。

首先是大公司和创业公司在发展速度上的本质差异。

TPU首次发布是在2013年,到今年5月最新推出的TPUv6,团队已经有了十多年开发经验。珠玉在前,系统设计和微架构很难有较大变动,更多的是迭代性、渐进式的改进。

加入OpenAI则不同,在从头开始设计、开发的过程中,成员们有机会尝试更创新、更激进的方法。

而且OpenAI一向雄心勃勃,他们的目标是构建由数百万个加速器组成的系统,这比GPT-4的训练还要大好几个数量级。

此外,团队合作模式也有很大的区别。

在尾大不掉的谷歌,虽然TPU团队也会和DeepMind合作,但依旧会遇到不少非技术方面的障碍。

相比之下,OpenAI内部的芯片和模型团队之间,交流与合作会更为紧密顺畅。

除了这些,当然也有薪酬的差异。

实际上,Google TPU团队已经是半导体设计领域中薪酬最高的团队之一,工程师的平均收入远高于AMD、英特尔、高通等大多数半导体公司,能和行业龙头英伟达比肩。

OpenAI的基本工资虽然没那么丰厚,但作为未上市的创业团队,每年向高级工程师提供的价值数百万美元的股权更加诱人。

有了这几重因素的叠加,再加上CEO奥特曼本人亲自参与了大部分的招聘工作,OpenAI招募到的人才质量令人惊叹。

GPT-4o和Sora模型发布时,团队成员背景、能力之强悍总能惊艳到网友。

SemiAnalysis的记者向同行打听这些被挖角的TPU人才时,总能得到这样的回答,「他们是我合作过的最好的工程师之一」。

OpenAI之所以瞄准谷歌的TPU团队,既是希望得到最先进的技术和人才,也同样有商业竞争上的考量。

在硅谷的众多科技巨头中,只有谷歌研发的TPU能成功替代英伟达的芯片,并部署在公司内部的云服务中。

Meta、亚马逊和微软等公司虽然也在自研芯片方面做了很多努力,但依旧严重依赖英伟达。

在未来相当长的时间内,AMD和英伟达等半导体公司将依旧是OpenAI的合作伙伴,因此轻易得罪不起。

只有面对天生的死对头——谷歌,OpenAI才敢如此肆无忌惮地挖角。(连发布会都要抢在谷歌I/O大会前一天开)

虽然已经获得了如此强大的人才团队,但是芯片研发依旧需要付出巨大的努力。

预计要到2027年底,OpenAI才能推出第一代自研芯片。在那之前,他们依旧会完全依赖商用芯片。

与微软关系逐渐微妙

OpenAI自研芯片的决策有些让人摸不到头脑。背靠微软的资金和Azure云服务的强大算力,为什么要烧钱自研芯片?

实际上,OpenAI的与微软之间的关系已经愈发紧张,因为对于微软而言,OpenAI是一家结构非常怪异的公司。

目前,它本质上依旧是一家完全独立的非营利组织,由OpenAI Nonprofit管理。微软作为无投票权的董事会观察员,几乎无法控制OpenAI的发展走向。

如果因为AGI安全问题,OpenAI董事会要求中止协议、收回模型的使用权,微软就只能乖乖听命,毫无还手之力。

AGI从所有的商业和知识产权许可协议中分割开来。

董事会决定我们何时实现AGI。再次强调,AGI指的是一种高度自治的系统,在最具经济价值的工作中优于人类表现。此类系统不包括在与微软签订的IP许可和其他商业条款中,这些条款仅适用于AGI之前的技术。

因此,两方面都在施行自己的「脱钩」计划。

OpenAI需要在芯片和算力方面逐渐独立,微软在试图减少对OpenAI模型的依赖。

比如微软近期投资Inflection AI,以及自行组建团队开发Phi-3、MAI-1等模型,都是出于这方面的考量。

目前,许多企业用户通过Azure使用OpenAI的技术,包括超过65%的《财富》500强公司。

注重与年轻人同频的小熊电器,显然是后者。这个刚满18岁的小家电品牌,十分擅长和年轻人对话,也很了解他们的内心渴求。所以在行业野蛮生长的前几年,小熊电器没有选择盲目跟风扩张,而是坚定做强刚需品类、做大新兴品类,通过打造更为全面而系统的解决方案,去满足不同场景下的用户生活需求。

定制化妆品“走红”美博会 为美业发展开辟新道路

微软希望拥有自研的GPT-4级别LLM,以及满足不同用户需求的一系列模型,以便在Azure的推理服务中替换掉OpenAI。

对于OpenAI来说,想要在算力方面自给自足,购买英伟达芯片的成本过高,并不是最好的选择。因此,自研芯片似乎是唯一出路。

实际上,不仅仅是OpenAI,Meta、微软、谷歌和亚马逊等公司也都在大力投资,开发自己的AI加速器。

这些AI巨头一边是英伟达最大的客户,一边也成为最有力的竞争对手。

毕竟,在模型训练的过程中,算力已经成为占比最大的支出。如果能将购置芯片的资金转变为内部投入杠杆炒股的app合法吗,以制造成本部署GPU或TPU,模型的成本也将大幅下降。